本文目录导读:

随着互联网的发展和智能化进程的加速,网站数量呈现出爆炸式增长,对于那些希望利用Python、JavaScript等编程语言实现自动化爬取网站信息的用户来说,编写简单的自动爬塔脚本是一种非常实用的技术工具。

我们将介绍如何编写一个简单自动爬塔脚本,以帮助你更好地理解和掌握爬虫技术,我们还将分享一些实际的案例和应用场景,以便你在实践中积累经验。

理解爬虫的基本概念

我们需要了解什么是爬虫,爬虫是一类自主地从网络上获取数据并进行分析的人工程序,爬虫的工作原理主要是通过模拟浏览器行为来抓取网页内容,包括HTML标签、文本、图像、视频等。

选择合适的编程语言

根据你的需求和技能水平,可以选择Python、JavaScript等适合的编程语言,Python是一个功能强大的脚本语言,语法简洁明了,易于学习和使用;JavaScript则是一个动态网页开发的语言,适用于创建动态网页应用。

设计爬虫架构

在编写爬虫时,你需要考虑以下几点:

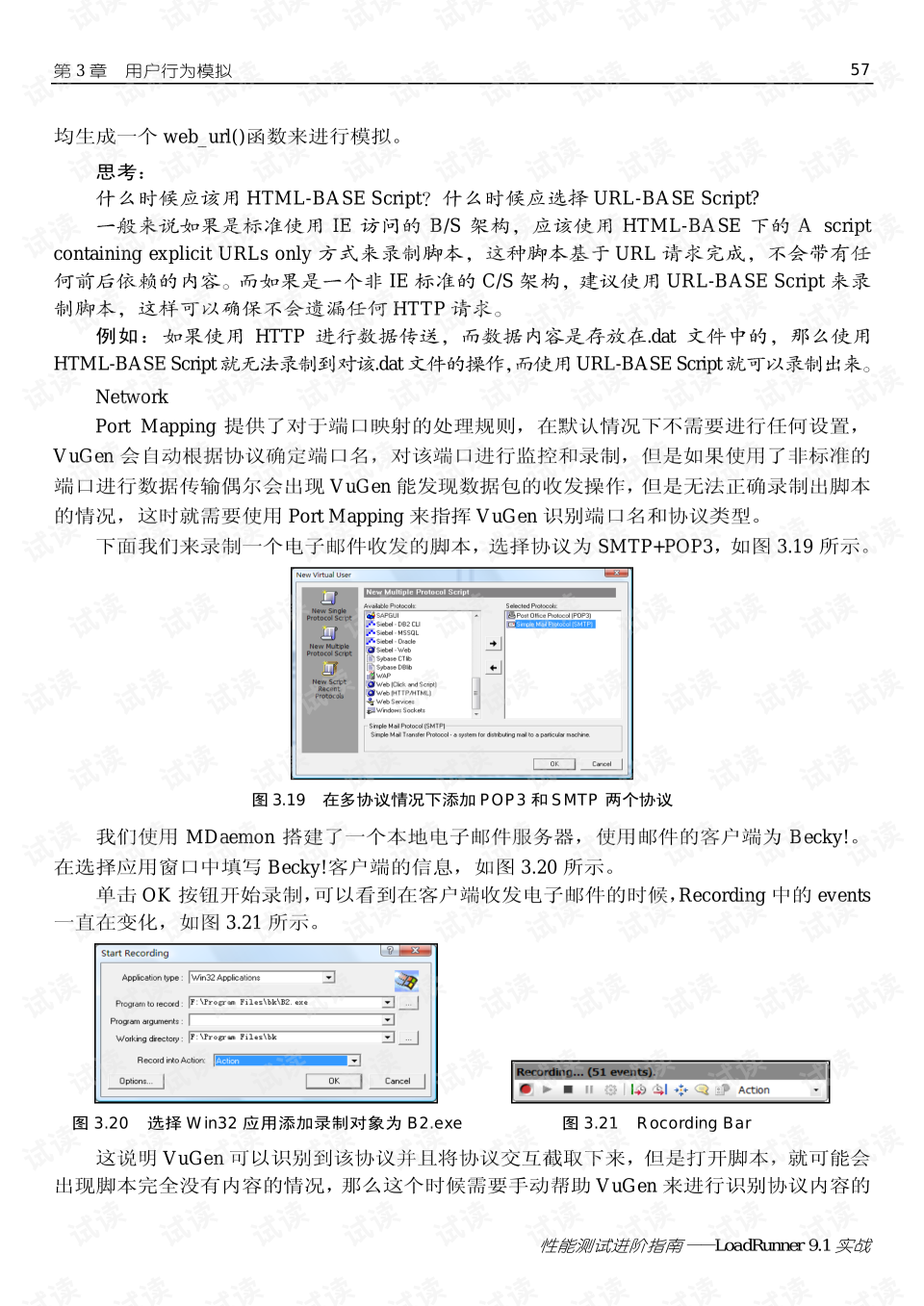

1、爬虫的请求参数:确定你要爬取的网页上的哪些元素可以被爬取,以及它们应该出现在哪些URL上。

2、连接网络:设定要发送HTTP请求到目标服务器的IP地址和端口号,并设置请求头,例如认证信息、User-Agent等。

3、处理响应:收到响应后,需要解析返回的数据,并将结果保存在变量或内存中。

4、限制爬取次数:为了防止过度爬取导致的法律责任问题,需要设定爬取时间间隔,或者设置爬取的最大频率。

编写爬虫代码

以下是一个简单的Python爬虫脚本示例,它会从Google首页爬取文本信息。

import requests

from bs4 import BeautifulSoup

def get_html(url):

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

return soup.prettify()

url = 'https://www.google.com'

print(get_html(url))在这个例子中,我们首先导入了requests库,用于发送HTTP请求;然后定义了一个函数get_html,该函数接受一个URL作为参数,使用requests库发送GET请求,并使用BeautifulSoup库解析返回的HTML文本。

调试和优化

爬虫脚本编写完成后,还需要对其进行调试和优化,检查请求是否成功发送,是否存在解析错误;检查是否有反爬虫机制,如何处理验证码、登录验证等问题;如果发现性能瓶颈,可以通过增加服务器压力测试、优化算法等方式解决。

编写一个简单自动爬塔脚本是一项需要综合运用编程技术和数据分析能力的任务,希望这篇指南能帮助你更好地理解和掌握爬虫技术,如果你在编写过程中遇到任何问题,都可以向我提问,我会尽力为你提供解答。

随着互联网的发展,爬取数据成为了许多人的兴趣爱好,我们将介绍一款简单的自动爬塔脚本,帮助用户轻松爬取目标网站的数据。

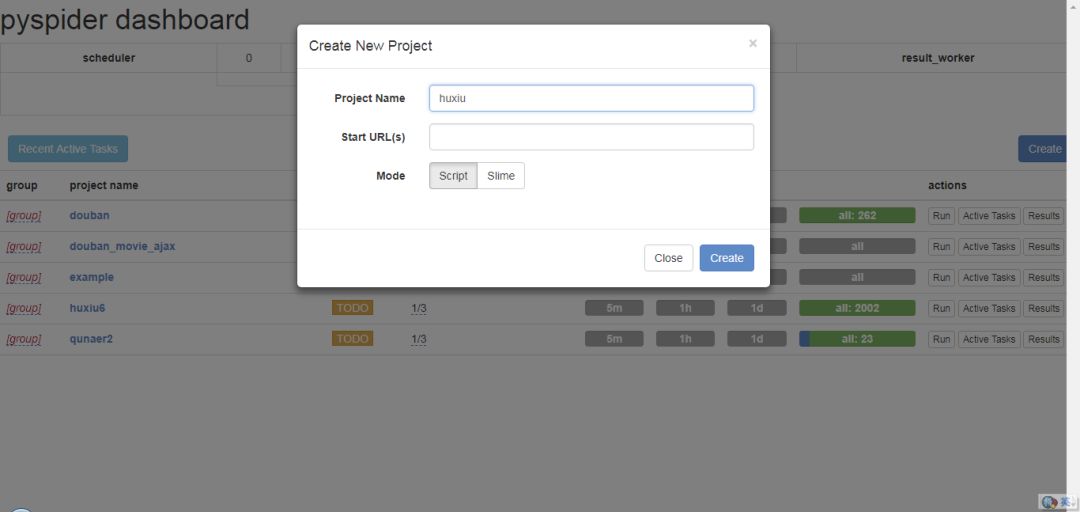

脚本简介

该自动爬塔脚本采用了Python编程语言编写,适用于各种网站的数据爬取,脚本具有简单易用、高效稳定的特点,可以快速爬取目标网站的数据,用户只需将要爬取的网站URL输入到脚本中,即可自动完成爬取任务。

脚本功能

1、智能选择目标网站:根据用户输入的URL,自动选择目标网站。

2、高效爬取数据:采用高效的爬虫技术,快速抓取目标网站的数据。

3、定时任务:支持定时任务功能,可以设置自动爬取的时间间隔。

4、数据处理:对抓取到的数据进行清洗、整理,以便后续使用。

使用方法

1、准备要爬取的网站URL。

2、打开脚本,将要爬取的网站URL输入到脚本中。

3、设置自动爬取的时间间隔和爬取频率等参数。

4、运行脚本,等待爬取完成即可。

注意事项

1、遵守法律法规:在使用自动爬塔脚本时,必须遵守相关法律法规,不得进行恶意爬取等违法行为。

2、保护用户隐私:在爬取数据时,必须保护用户隐私,不得泄露用户个人信息。

3、定期更新和维护:脚本需要定期更新和维护,以保证其稳定性和高效性。

这款简单挂自动爬塔脚本可以帮助用户轻松爬取目标网站的数据,在使用时,需要注意遵守法律法规、保护用户隐私、定期更新和维护等注意事项。